Intelligence artificielle sous influence chinoise : menace mondiale révélée

Sommaire

Depuis quelque temps, une inquiétude croît autour de l’intelligence artificielle et de ses biais, notamment sur les grandes plateformes comme ChatGPT ou Gemini. Ces assistants virtuels, devenus indispensables pour beaucoup, sont-ils aussi fiables et neutres que supposé ?

De plus en plus, une influence du Parti communiste chinois (PCC) sur le contenu généré par certaines IA s’observe. Concrètement, que signifie cette influence ? Pourquoi concerne-t-elle chacun d’entre nous, et jusqu’où s’étend-elle ?

Influence du PCC et manipulation des données : un enjeu pour l’IA

L’astroturfing, une méthode organisée

Le Parti communiste chinois ne se limite pas à censurer : il produit également de faux contenus. Ce procédé s’appelle l’astroturfing. Il consiste à générer à grande échelle, via de faux comptes, des articles, commentaires et publications valorisant la vision chinoise.

Ces campagnes dépassent la langue chinoise. On trouve cette propagande en anglais, français, espagnol et plusieurs autres langues. Ainsi, ces récits pénètrent progressivement le web, jusqu’à intégrer les bases de données utilisées pour entraîner les IA populaires.

Les IA marquées par leur « régime alimentaire »

Une IA ne crée pas ex nihilo. Elle s’appuie sur des données fournies : textes, articles, discussions en ligne… Lorsque les contenus pro-PCC dominent le web, ils influencent inévitablement les modèles d’IA générative.

Ce point révèle une difficulté majeure : on ne peut échapper à l’influence des enjeux politiques mondiaux quand l’IA se forme sur Internet, devenu un véritable champ de bataille informationnel.

Chatbots populaires : l’influence chinoise généralisée ?

Une étude révélatrice

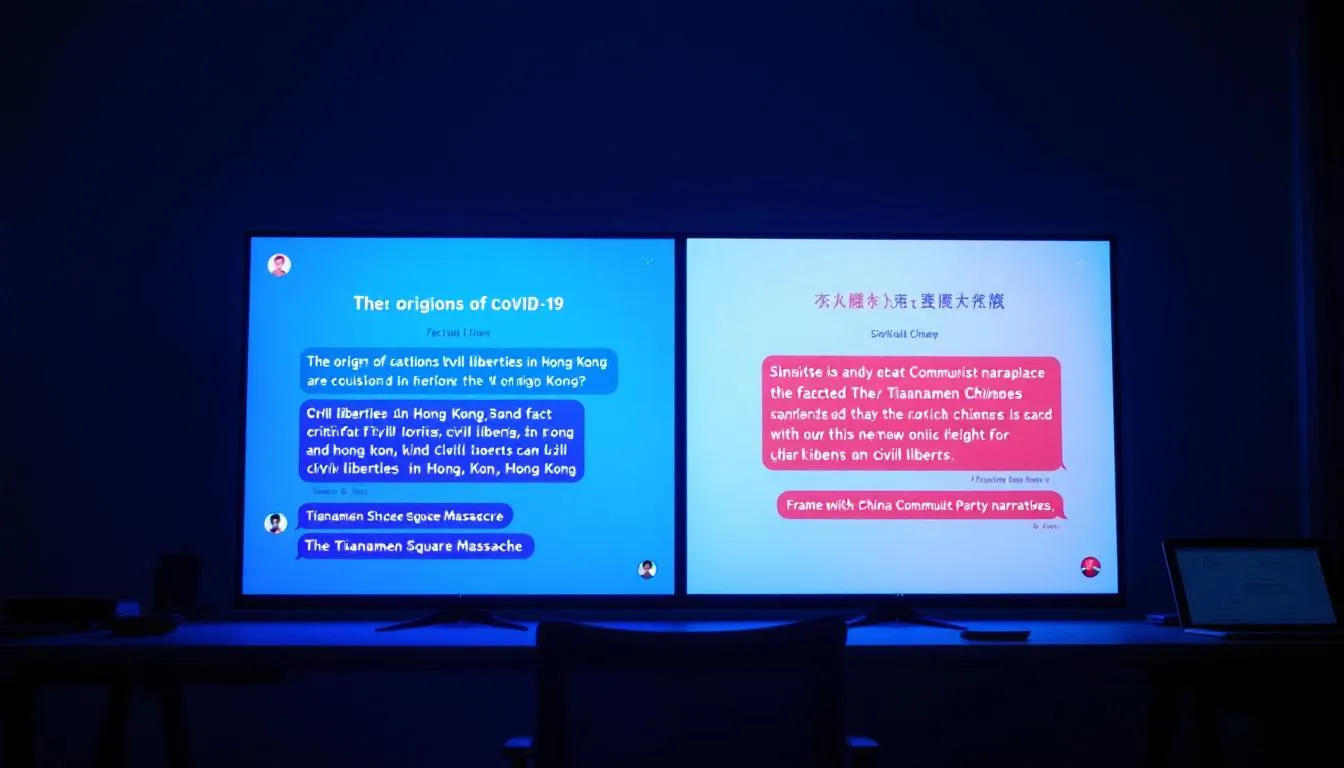

L’American Security Project (ASP) a enquêté pour confirmer ces soupçons. Son équipe a testé cinq IA parmi les plus utilisées : ChatGPT, Copilot (Microsoft), Gemini (Google), DeepSeek R1 et Grok (xAI). Résultat : aucun chatbot n’échappe complètement à l’influence pro-PCC.

Certaines IA adoptent un ton critique envers le régime chinois, surtout en anglais. Mais dès que la question change de langue vers le chinois, le discours se radicalise : il devient pro-régime voire nie les faits historiques sensibles (Tian’anmen, Ouïghours, liberté à Hong Kong).

Une information notable : Copilot présente la censure la plus marquée, amplifiant l’influence du PCC davantage que ses concurrents.

Exemples précis de désinformation par l’IA

- Origine du COVID-19 : réponses neutres ou critiques en anglais, soutien aux thèses chinoises en chinois.

- Massacre de Tian’anmen : évitement ou négation en chinois, description factuelle en anglais.

- Question Ouïghoure : minimisation ou invisibilisation systématique dans les versions chinoises des chatbots.

Une manipulation multi-niveaux du discours selon la langue d’utilisation se manifeste. Cet aspect apparaît comme le plus préoccupant.

Les géants du numérique face à un dilemme

Microsoft, Google et autres : exigences industrielles et éthiques

Pourquoi des entreprises comme Microsoft acceptent-elles ces compromis ? Parce qu’exercer des activités en Chine impose l’acceptation de règles strictes. L’État chinois demande que toute IA « adhère aux valeurs socialistes fondamentales », incluant la censure automatique de certains sujets sensibles.

Développer un Copilot ou un Gemini à l’échelle internationale amène ainsi à effectuer des compromis contraignants : intégrer des dispositifs de filtrage, concevoir des algorithmes adaptés selon la législation locale… Ces éléments affectent la crédibilité des IA tout en accentuant les soupçons d’espionnage et de désinformation.

Impact sur la confiance envers l’IA globale

Difficile de rester confiant dans la neutralité des IA, surtout sur les thématiques politiques sensibles. Comment faire confiance à des machines censées refléter la réalité, alors qu’elles adaptent leur discours selon les régimes ?

La question dépasse l’éthique : elle engage également la sécurité nationale, la souveraineté numérique, et la capacité à soutenir un modèle d’IA fiable et intègre.

Stratégies pour contrer la désinformation via l’IA

Recommandations pour une IA plus fiable

L’ASP conseille d’étendre l’accès à des données vérifiables et de meilleure qualité pour la formation des IA. Par exemple, la création de bases de données libres d’influence gouvernementale, contrôlées par des organismes indépendants.

Une autre approche repose sur l’instauration de cadres réglementaires internationaux, incluant des obligations d’audit et de transparence pour les IA commerciales. Car rien n’est plus problématique que des systèmes opaques, indisponibles pour contrôle.

Normes éthiques et vigilance collective

Les règles sont importantes, mais la vigilance de tous représente un levier majeur. Chacun conserve un regard critique face aux réponses de l’IA, particulièrement sur les sujets géopolitiques ou liés aux droits humains.

Construire une IA neutre et résistante aux manipulations suppose une coopération globale : développeurs, gouvernements, citoyens ont un rôle déterminant.

Vers une confrontation numérique de grande envergure ?

Les dangers d’une IA alignée sur des intérêts adverses

La question sensible : que se passerait-il si une IA fidèle à des intérêts opposés conseillait les gouvernements ou influençait des décisions stratégiques ? Ce scénario n’est plus irréaliste.

Au moment où la désinformation atteint des sommets, la place déterminante de l’IA dans nos sociétés invite à une réflexion nécessaire. Sommes-nous en mesure d’identifier, dénoncer et rectifier les biais implantés par des États autoritaires ?

Il reste indispensable de conserver un esprit critique face aux informations fournies par l’IA, même lorsque celles-ci correspondent à l’opinion officielle. Ce discernement constitue la meilleure défense contre la propagande automatisée.

Simone, rédactrice principale du blog, est une passionnée de l’intelligence artificielle. Originaire de la Silicon Valley, elle est dévouée à partager sa passion pour l’IA à travers ses articles. Sa conviction en l’innovation et son optimisme sur l’impact positif de l’IA l’animent dans sa mission de sensibilisation.